Netarkivet indsamler vores internethistorie

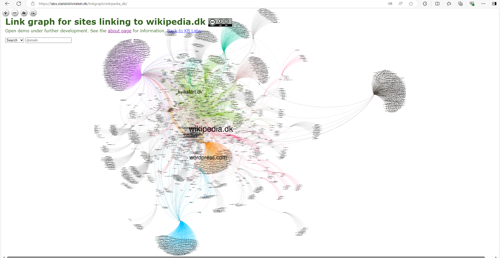

Illustration Det Kgl. Bibliotek

Siden 2005 har Netarkivet, der hører under Det Kgl. Bibliotek, indsamlet den danske del af internettet. Det giver forskere adgang til et unikt indblik i dansk internethistorie.

- Vi høster principielt alle typer af information på det danske net. For vi ved jo ikke, hvad forskerne vil interessere sig for i fremtiden. Men vi kan umuligt høste al data, siger Anders Klindt Myrvoll, der er faglig leder af Netarkivet.

Netarkivet har siden 2005 indsamlet materiale fra den danske del af internettet og bevaret det i et webarkiv. Helt præcist indsamler Netarkivet offentligt tilgængeligt materiale udgivet på internettet på dansk, af danskere eller henvendt til danskere, fordi det er en vigtig del af den danske kulturarv, som Netarkivet, som en del af Det Kgl. Bibliotek, ifølge pligtafleveringsloven, skal bevare for eftertiden

- Ved at arkivere internettet bevarer vi som samfund en afgørende del af vores digitale verden og kulturarv og ikke mindst, så har vores forskere adgang til det efterfølgende, forklarer Anders Klindt Myrvoll. Det handler grundlæggende om at værne om Danmark som et oplyst og demokratisk samfund, hvor adgangen til den danske kulturarv på nettet er væsentligt.

For vil man studere nyere historie, har man brug for at kunne se f.eks. online nyheder, profiler på sociale medier eller hjemmesideopdateringer. Men samstemmende for alle tre kilder er, at indholdet løbende ændres eller fjernes. Det ville for eksempel være næsten umuligt for en forsker at gå tilbage og få et dækkende billede af, hvordan kommunikationen om Corona udviklede sig fra starten til slutningen af pandemien, hvis ikke Netarkivet havde høstet informationerne. Dette arbejde er vigtigt, hvad enten forskeren har brug for at kende indholdet på tværs af internettet eller se, hvordan en konkret hjemmeside så ud på et givent tidspunkt.

- Netarkivet er ikke et teknologisk museum, men en levende samling med løbende tilvækst og en vedvarende vigtig og unik kilde til dansk digital kulturarv på Det Kgl. Bibliotek. siger Anders Klindt Myrvoll og tilføjer, at en større del af de danske domæner og andet væsentligt indhold såsom links eller undersider på eksisterende hjemmesider forsvinder på et år. Dermed forsvinder vigtige kilder til informationer om bestemte begivenheder eller personer, hvis vi ikke som samfund indsamler dem, gemmer dem og gør dem søgbare.

Hvordan høster man internettet?

Indsamlingen af internettet foregår med såkaldte webcrawlere - en software, der indsamler internetmateriale, og der indsamles kun offentligt tilgængeligt materiale.

Netarkivet høster efter flere strategier. Der tages øjebliksbilleder af alle danske domæner 3-4 gange årligt, og der indsamles fra politiske partier, ministerier, udvalgte personers såsom politikeres sociale medier og nyhedsmedier. Indsamlingen af indhold fra sociale medier er dog langt vanskeligere end tidligere, og nyhedsmediers betalingsmure, kan også gøre opgaven mere kompliceret.

Netarkivet har desuden fokus på specielle begivenheder, det kan være en pandemi som Corona, valg til Folketinget, eller når særlige internetservices lukker ned, f.eks. som det skete for Google+ i 2019.

Hvert år i uge 46 indsamles der med særligt fokus på hjemmesider og programoversigter for danske lokale radio- og tv-stationer, og selve udsendelserne indsamles også i denne periode i Radio- og tv-samlingen. På denne måde kan samlingerne supplere hinanden. Hensigten med de forskellige strategier er, at de kombineret med hinanden giver den bedst mulige dækning af, hvad der offentliggøres på den danske del af internettet.

Siden Netarkivet indsamlede det første internetmateriale i 2005, er der blevet indsamlet meget data, der bevares i 3 kopier (rent teknisk således, at én kopi opbevares som et online arkiv, mens de to øvrige opbevares på bånd) for at sikre, at intet går tabt. Kopierne bruger forskellig software og medier og er placeret forskellige steder i landet for at opnå så god bevaring, som muligt.

I dag fylder arkivet 1.32 petabytes (PB), hvilket svarer til 1320 terabytes (TB) (1 TB fylder 20 hyldekilometer papirarkivalier) eller over 45 milliarder objekter (pr. 25. oktober 2024 helt præcist 45.653.506.201) - alt fra billeder, pdf’er til html-filer.

Netarkivet er ikke et teknologisk museum, men en levende samling med løbende tilvækst og en vedvarende vigtig og unik kilde til dansk internethistorie.Anders Klindt Myrvoll

Fritekst søgning og datasæt

Indsamlingen betyder, at forskere har en unik mulighed for at søge i Netarkivet, der kun må benyttes til videnskabelige formål, fordi det indeholder følsomme personoplysninger og ophavsretligt beskyttet materiale. Siden 2015 har forskere kunnet lave fritekstsøgninger i arkivet, og fra 2016 udviklede Det Kgl. Bibliotek open source-softwaren SolrWayback, der sikrer, at forskerne både kan søge i fritekst og i billeder, geografiske data, visualisere søgeresultater og eksportere grafer, data og statistik.

Siden 2018 har forskere også kunnet få udleveret datasæt, og dermed er forskerne godt hjulpet, når de skal dykke ned i internettets historik. Et eksempel er Center for Social Data Science fra Københavns Universitet, der i et forskningsprojekt har bedt om al dansk tekst fra Netarkivet for at finde gemte mønstre, fremme præcisionen i sprogmodeller og bidrage til udviklingen af den digitale kultur i Danmark. Det blev 35 terabyte (TB) med indhold.

En af grundene til at der er så store mængder af tilgængeligt data fra det danske internet er, at det danske Netarkiv var hurtigt ude af starthullerne med indsamling allerede i 2005. Netarkivet har også etableret samarbejder internationalt for hele tiden at dele viden om, hvordan man bedst muligt indsamler, opbevarer og gør indholdet søgbart.

For der er udfordringer.

Hvordan sikrer man f.eks., at der er overensstemmelse mellem det, der indsamles fra nettet og internettets reelle indhold, når internettet ændrer sig konstant, og hvor de tekniske fremskridt er store og hvor formater ændrer sig løbende?

- Det var lettere i gamle dage hvor teknologien bag en hjemmeside var markant mere enkel, er den tørre konstatering fra Anders Klindt Myrvoll.

Han peger på, at nogle af Netarkivets fokusområder lige nu er at dokumentere klimadebatten og klimaforandringer, hvor man blandt andet indgår i et pilotprojekt under Augustinusfonden, der har til formål at dokumentere reaktioner på klimaforandringernes påvirkning af offentlighed og hverdagsliv i Danmark. Et andet projekt, der har stort fokus er at forsøge at indsamle indhold fra et udvalg af de mange grupper, der er etableret på Facebook, fordi det for forskerne vil give et stort indblik i, hvad der optager danskerne.

- Udfordringen pt er, at vi bliver smidt ud eller blokeret, hvis vi forsøger at crawle på Facebook eller YouTube, samt at det er svært teknologisk at indsamle medier som disse. Hvis vi kunne crawle alt indhold fra sociale medier, ville vi derudover stå med en enorm udfordring ift. datamængden. Kommercielle udbydere har ikke nødvendigvis nogen økonomisk interesse i at gemme indholdet eller gøre det tilgængeligt, det er en udfordring, fordi der er så meget indhold, der i dag skabes og debatteres på sociale medier, siger Anders Klindt Myrvoll, der har et godt råd, hvis man selv vil gøre det lettere at sikre, at ens hjemmesides indhold bevares for eftertiden. Nemlig at have et sitemap med absolutte links til alle sider – også pagineret indhold og sider, der vises efter brugervalg.

Få meget mere viden om Netarkivet

Hvis du vil vide mere om Netarkivet, hvordan det arbejder og hvordan du kan bruge det som forsker, så tilmeld dig webinaret “Bliv klogere på Det Kgl. Biblioteks Netarkiv”